O que é Robots.txt?

Robots.txt é um arquivo de texto utilizado para comunicar-se com os motores de busca, como Google, Bing e Yahoo. Este arquivo especifica quais partes de um site devem ou não ser analisadas pelos robôs de busca. A sua correta configuração é fundamental para garantir que o conteúdo desejado seja indexado, enquanto informações sensíveis ou irrelevantes possam ser mantidas fora dos resultados de busca.

Importância do Robots.txt para SEO

A importância do arquivo Robots.txt para SEO não pode ser subestimada. Ele ajuda a direcionar o tráfego de busca para as páginas mais relevantes do seu site, evitando que conteúdos duplicados ou de baixa qualidade sejam indexados. Isso não apenas melhora a experiência do usuário, mas também contribui para a classificação do site nos motores de busca.

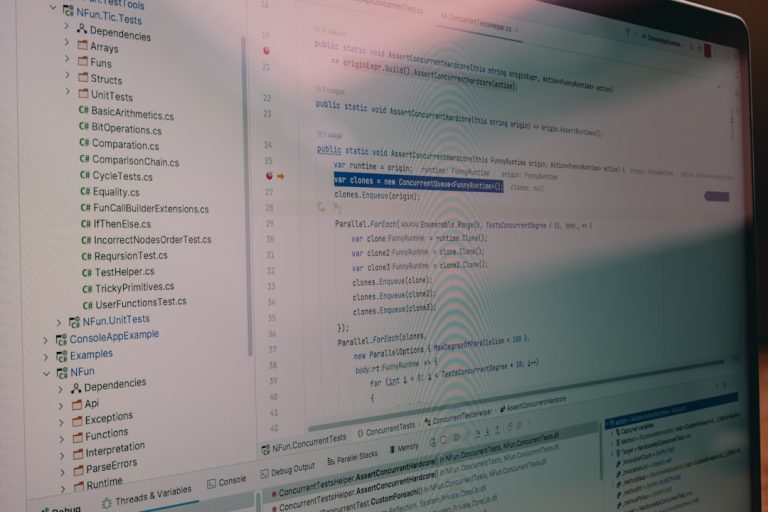

Como Criar um Arquivo Robots.txt

Para criar um arquivo Robots.txt, você deve usar um editor de texto simples e salvá-lo com o nome ‘robots.txt’. O arquivo deve ser colocado no diretório raiz do seu site. A estrutura básica do arquivo inclui diretivas que instruem os motores de busca sobre quais seções do site devem ser permitidas ou bloqueadas. Um exemplo comum é ‘User-agent: *’ para se referir a todos os robôs.

Diretivas Comuns no Robots.txt

As diretivas mais comuns no Robots.txt incluem ‘Disallow’, que impede o acesso a determinadas URLs, e ‘Allow’, que permite acesso a seções específicas. Por exemplo, ‘Disallow: /privado/’ bloquearia a indexação de qualquer página na pasta ‘privado’. É importante conhecer essas diretivas para otimizar o desempenho do seu site nos motores de busca.

Erros Comuns ao Configurar o Robots.txt

Um erro comum ao configurar o Robots.txt é bloquear acidentalmente páginas importantes do seu site. Outro problema frequente é a falta de formatação correta, o que pode levar a mal-entendidos por parte dos motores de busca. Por isso, é essencial revisar o arquivo antes de implementá-lo, garantindo que a sintaxe esteja correta e que as páginas desejadas sejam acessíveis.

Ferramentas para Testar o Robots.txt

Existem diversas ferramentas que facilitam a validação do seu arquivo Robots.txt. O Google Search Console, por exemplo, possui uma ferramenta de teste que permite verificar se o arquivo está configurado corretamente. Usar essas ferramentas pode evitar problemas de indexação e ajudar a otimizar a presença do seu site nos motores de busca.

Impacto do Robots.txt na Experiência do Usuário

Um Robots.txt bem configurado não apenas melhora o SEO, mas também impacta diretamente a experiência do usuário. Ao garantir que o conteúdo relevante esteja acessível e que as páginas de baixa qualidade não sejam indexadas, você proporciona uma navegação mais fluida e satisfatória para os visitantes do seu site.

Atualizações e Manutenção do Robots.txt

A manutenção regular do arquivo Robots.txt é crucial, especialmente após a adição de novas páginas ou a reestruturação do site. É recomendável revisar o arquivo sempre que houver mudanças significativas no conteúdo ou na estrutura do site, garantindo que a indexação continue a ser otimizada e que as páginas desejadas permaneçam acessíveis.

Exemplos Práticos de Robots.txt

Para ilustrar, um exemplo prático de um arquivo Robots.txt poderia ser:

‘User-agent: *

Disallow: /admin/

Allow: /public/’. Este exemplo bloqueia o acesso à pasta de administração, mas permite que a pasta pública seja totalmente indexada. Estudar exemplos pode ajudar na criação de um arquivo eficaz e otimizado.